Core Concepts

少数言語を含む200言語に対応する単一の大規模多言語モデルを開発し、従来の最先端モデルに比べて平均44%の翻訳品質向上を実現した。

Abstract

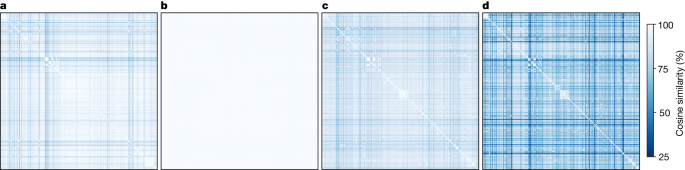

本研究では、7,000以上の言語の中でも特に少数言語を含む200言語に対応する単一の大規模多言語神経機械翻訳モデルを開発した。従来の研究は主に高資源言語の翻訳品質改善に注力していたが、それでは長期的に見て言語間の格差が拡大してしまう。そこで本研究では、低資源言語にも注目し、転移学習を活用したスパースな専門家混合モデルを提案した。さらに、過剰適合を防ぐための建築的・訓練上の改善も行った。開発したモデルの性能を、自動ベンチマーク(FLORES-200)、人間評価メトリクス(XSTS)、言語横断的な有害性検出器を用いて評価した結果、従来の最先端モデルに比べて平均44%の翻訳品質向上を実現した。本研究の成果は非商用利用のために公開されており、汎用的な翻訳システムの開発に向けた重要な基盤を提供するものである。

Scaling neural machine translation to 200 languages - Nature

Stats

7,000以上の言語が存在する中で、本研究では200言語に対応したモデルを開発した。

従来の最先端モデルと比較して、平均44%の翻訳品質向上を実現した。

Quotes

"本研究では、少数言語を含む200言語に対応する単一の大規模多言語神経機械翻訳モデルを開発した。"

"開発したモデルの性能を評価した結果、従来の最先端モデルに比べて平均44%の翻訳品質向上を実現した。"

Key Insights Distilled From

by Mart... at www.nature.com 06-05-2024

https://www.nature.com/articles/s41586-024-07335-x

Deeper Inquiries

少数言語の翻訳品質向上には、どのようなデータ収集や前処理の工夫が必要だろうか

少数言語の翻訳品質向上には、どのようなデータ収集や前処理の工夫が必要だろうか。

少数言語の翻訳品質向上には、いくつかの工夫が必要です。まず、低リソース言語向けのデータ収集手法を開発することが重要です。本研究では、新しい採掘技術を用いてデータを収集しましたが、これは他の言語にも適用可能な手法として有望です。さらに、前処理段階でのデータのクリーニングや整形も重要です。低リソース言語の場合、データの品質や量が不足していることが多いため、適切な前処理を行うことでモデルの学習効率を向上させることができます。

本研究で提案したモデルアーキテクチャの汎用性は、他のタスクにも適用できるだろうか

本研究で提案したモデルアーキテクチャの汎用性は、他のタスクにも適用できるだろうか。

提案されたモデルアーキテクチャは、他のタスクにも適用可能な汎用性を持っています。Sparsely Gated Mixture of Expertsアーキテクチャは、複数の専門家からなるモデルを活用しており、異なる言語間での転移学習にも適しています。このアーキテクチャは、他の自然言語処理タスクや多言語間の情報共有など、さまざまな領域に応用することができます。

人工知能の発展により、言語の壁がなくなることで、人類の知識共有や相互理解がどのように変化するだろうか

人工知能の発展により、言語の壁がなくなることで、人類の知識共有や相互理解がどのように変化するだろうか。

人工知能の発展により、言語の壁がなくなることで、人類の知識共有や相互理解が大きく変化するでしょう。言語の壁を取り除くことで、異なる文化や地域間でのコミュニケーションが円滑になり、知識や情報の共有が促進されます。これにより、世界中の人々がより簡単に意見交換や協力を行うことが可能となり、グローバルなコミュニティの形成が進むでしょう。

0